Обзор Dell PowerEdge R670: 1 петабайт и 128 ядер в корпусе 1U

Dell PowerEdge R670 — это мощный сервер в форм-факторе 1U. Двухсокетные юнитовые серверы существуют целую вечность, но Dell умудрились в этом поколении накрутить столько нового, что возможности 1U сервера расширились. Больше места для хранения данных, более быстрые сетевые интерфейсы и новые ускорители расширяют возможности линейки серверов, которая с каждым поколением становится все лучше. Давайте познакомимся с Dell PowerEdge R670 поближе.

В этой статье:

- Внешний вид и передняя панель

- Внутреннее устройство сервера

- Топология и архитектура системы

- Удалённое управление iDRAC 10

- Тесты производительности

- Энергопотребление

- Оценка сервера (Server Spider)

- Выводы

Внешний вид

Первое, что бросается в глаза — лицевая панель. Она не просто для красоты: защищает SSD от случайного выдёргивания и добавляет меньше 2 мм к стандартной глубине сервера (815 мм / 32 дюйма). У Dell ещё есть конфигурация с фронтальным I/O, но с лицевой панелью она не совместима.

Слева — монтажное ушко для стойки.

Справа — второе ушко, сервисный порт USB Type-C и кнопка питания.

В центре — не привычные 8–10 отсеков U.2 2.5", а 16 отсеков E3.S. Можно раскачать до 20 штук на передней панели.

Каждый блок из 8 дисков по 61,44 ТБ даёт под 1 ПБ на 16 накопителей, а в конфигурации на 20 дисков — перевалишь за петабайт на один юнит. Ещё пару лет назад для такого нужно было собирать экзотическую СХД с нишевыми форм-факторами. Теперь это стандартная фича PowerEdge.

Преимущество конструкции E3.S заключается в том, что это более тонкий форм-фактор твердотельных накопителей, обеспечивающий более высокую плотность хранения данных.

С другой стороны, у нас тоже 8 дисков.

В серверах PCIe Gen6 разъем U.2 больше не будет поддерживаться, а для обеспечения целостности сигнала будет использоваться разъем EDSFF.

На фронтальной панели также есть сервисная метка Dell.

Сзади есть множество вариантов, но основные функции — два блока питания, слоты для дополнительных плат и блок ввода-вывода на задней панели — присутствуют.

В нашей сборке стоят два резервированных БП по 800 Вт — по одному с каждой стороны. Сделано для удобной кабельной разводки к стойкам с PDU по обоим бортам.

Оба — 800 Вт с сертификацией 80Plus Platinum.

Сзади расположены порт VGA, два порта USB Type-A и внеполосный порт iDRAC.

В этой конфигурации используются три низкопрофильных переходника. У Dell есть и другие варианты для карт разных размеров, накопителей на задней панели и т. д.

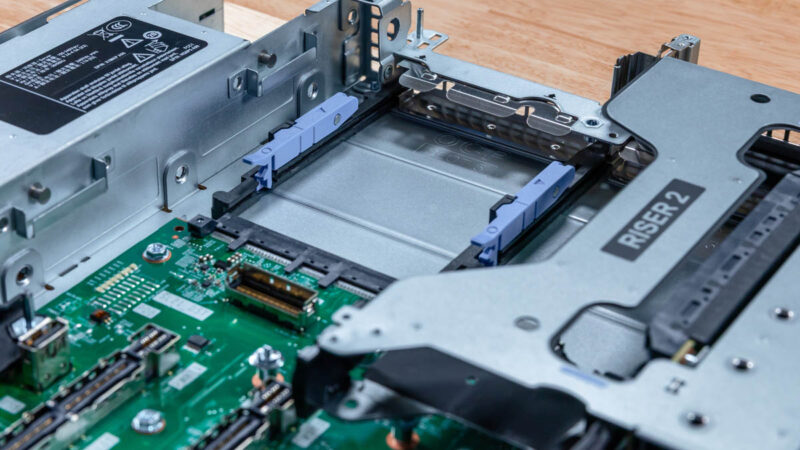

Riser 2 — два слота PCIe Gen5 x16 low-profile.

У Dell есть отличный переходник без инструментов. Кроме того, отличительной особенностью современных серверов являются кабели, добавляющие линии PCIe к переходникам.

Riser 4 — одиночный low-profile слот.

В переходнике есть удобная функция: переднюю и заднюю панели карт можно закрепить с помощью опор без использования инструментов. Это небольшая, но приятная мелочь.

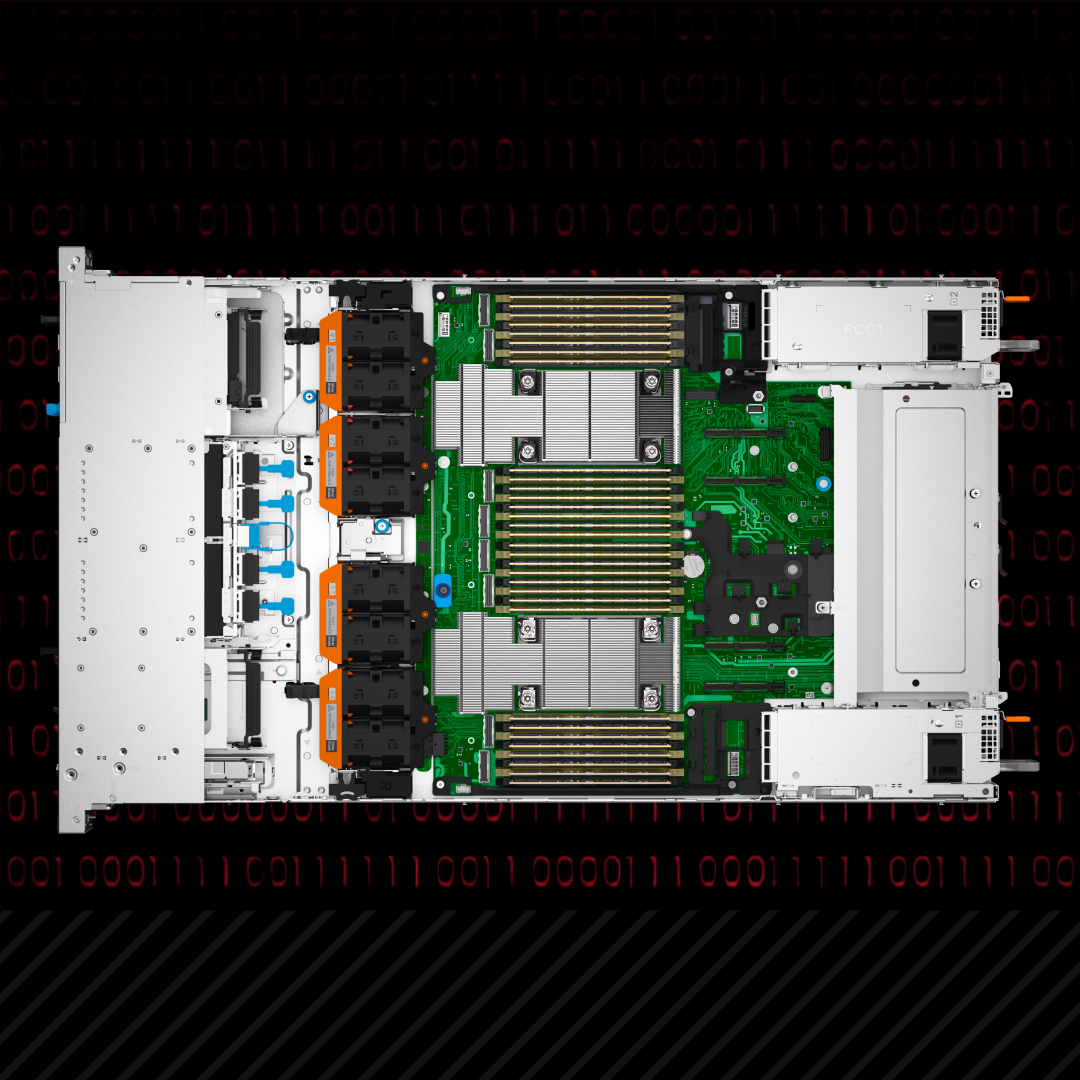

Внутреннее устройство сервера

Крышка снимается одним фиксатором.

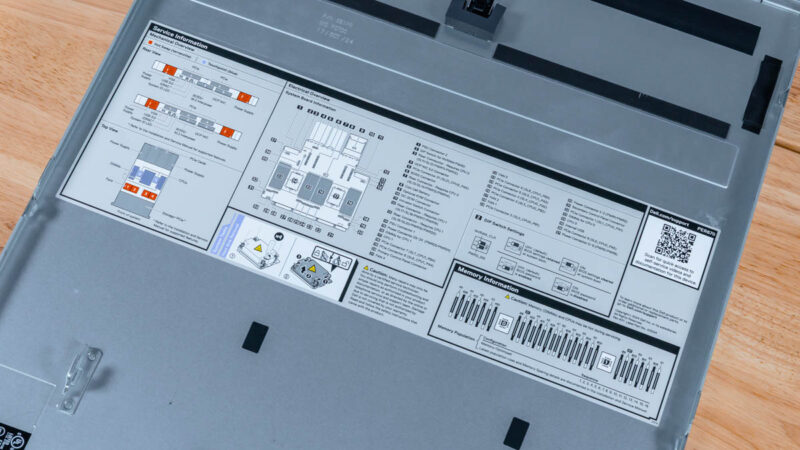

Кроме того, внутри крышки находится руководство по обслуживанию от Dell. В наши дни такие руководства становятся все более распространенными в отрасли, но Dell включает их в комплектацию уже много лет.

Как видите, спереди находится отсек для хранения данных, затем идут вентиляторы, за ними — процессоры и память, а в задней части — порты ввода-вывода.

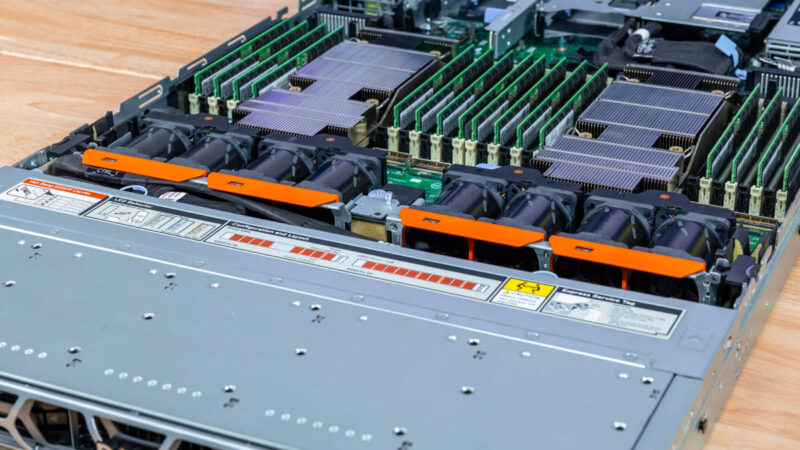

У Dell есть модули вентиляторов 1U с возможностью горячей замены. Это отличное решение, которое является лучшим в своем классе, поскольку его легко обслуживать. Известно, что вентиляторы 1U с возможностью горячей замены обслуживать сложнее, чем вентиляторы в серверах 2U, поэтому многие производители по-прежнему считают, что обслуживание заключается в отсоединении кабеля/разъема вентилятора.

А вот еще один взгляд с другой стороны.

Эти вентиляторы отвечают за охлаждение всей системы. Возможно, вы заметили небольшую особенность: вентиляторы расположены таким образом, что на каждый радиатор процессора направлен один вентилятор из двух разных модулей. Это обеспечивает резервирование на случай выхода из строя одного из модулей.

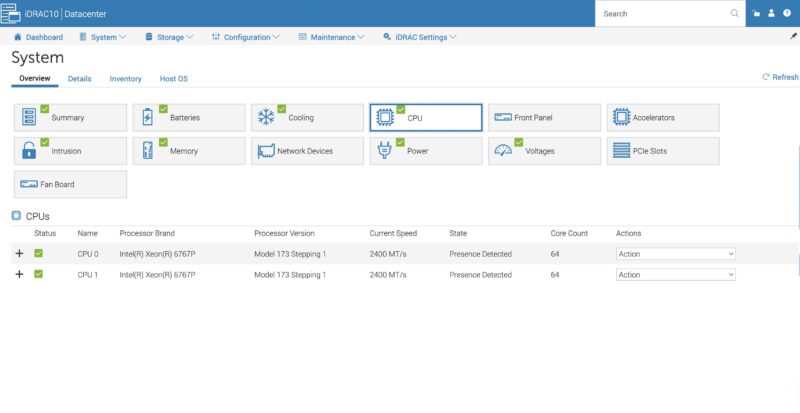

Серверу требуются два процессора Intel Xeon 6700E, 6700P или 6500P. В нашей системе установлены два процессора Intel Xeon 6767P, которые пользуются большим спросом. Мы протестировали несколько серверов с искусственным интеллектом на базе именно этих 64-ядерных процессоров, поскольку они обеспечивают баланс между количеством ядер, тактовой частотой и объемом памяти в сокете.

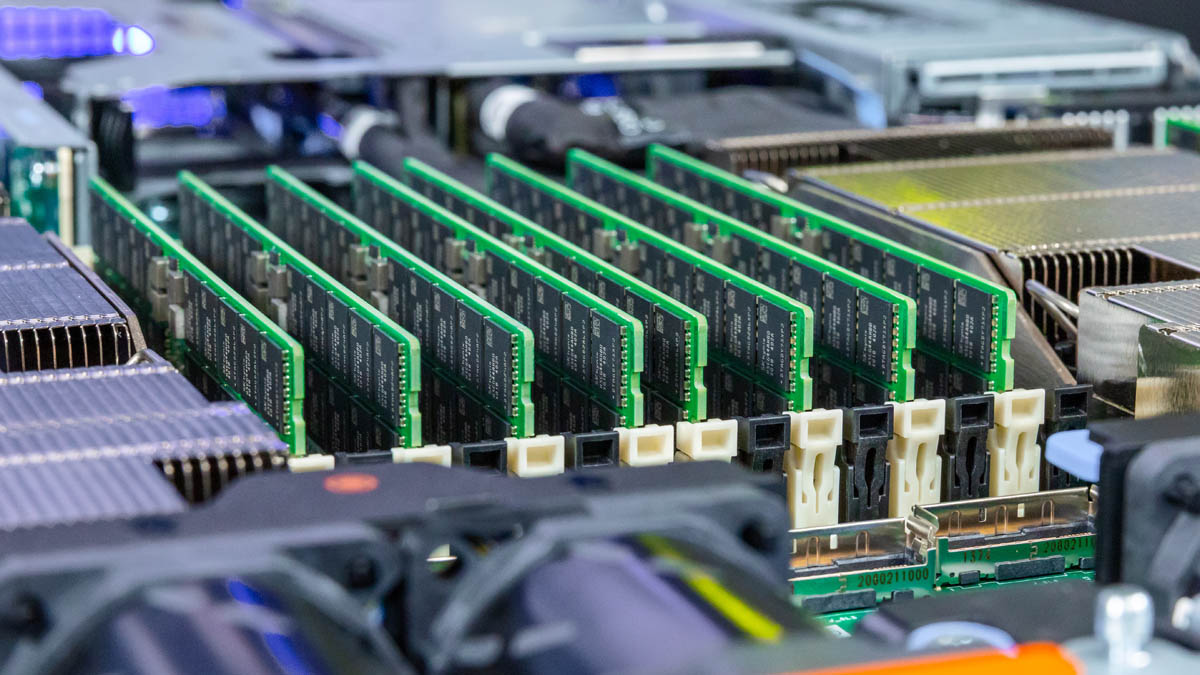

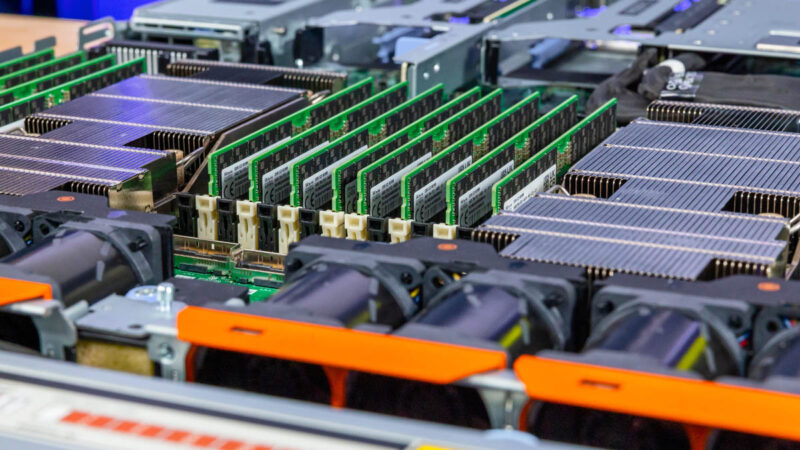

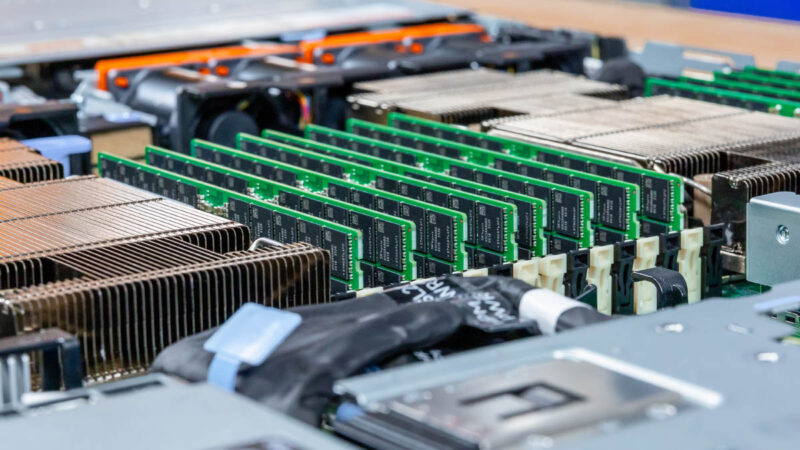

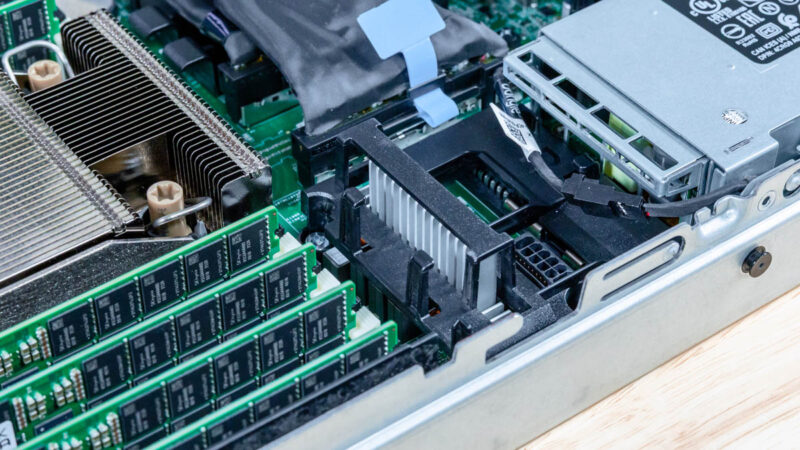

Здесь у нас полный комплект из 16 модулей памяти DDR5 RDIMM на каждый процессор, всего 32 модуля. Сокеты Intel Xeon серии 6900P более высокого класса имеют 12-канальную память, но из-за физической ширины, необходимой для установки такого количества модулей, их количество в системе ограничено 24 модулями. Это может показаться нелогичным, но на 8-канальных платформах Intel серии Xeon 6700 можно установить больше модулей памяти, чем на более дорогих 12-канальных платформах серии Xeon 6900.

При этом Dell обходится компактными радиаторами с минимальным выступом за сокет. Без монструозных конструкций — и всё равно охлаждает 350-ваттные процессоры.

Рядом с разъемом можно увидеть несколько кабельных разъемов PCIe.

Их можно использовать для таких функций, как подключение внешнего накопителя к шине PCIe.

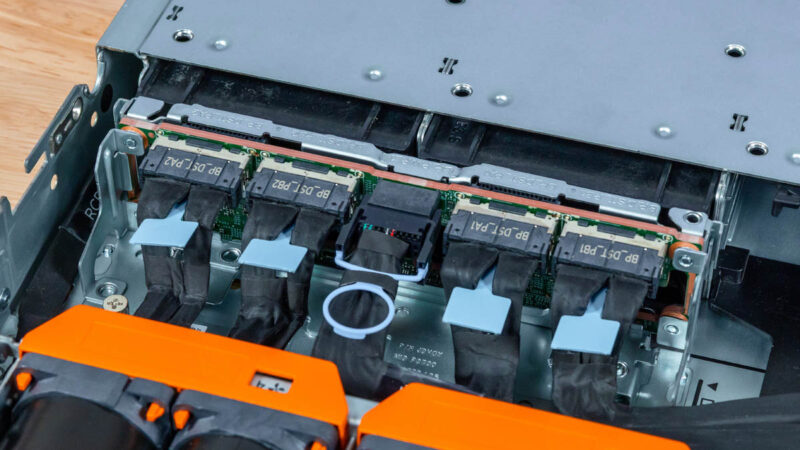

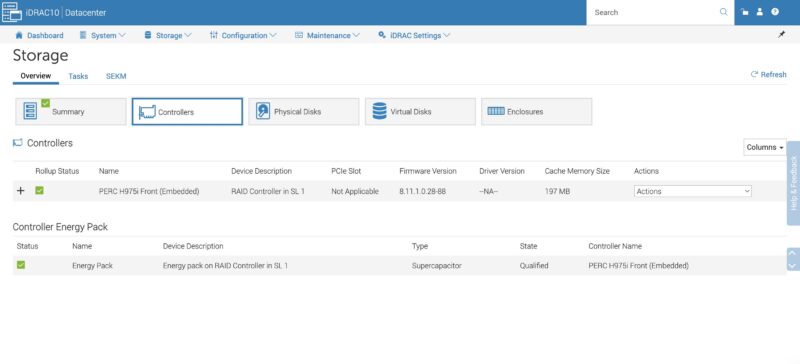

Вот пример объединительной платы для систем хранения данных с проводным подключением. Dell предлагает переднюю панель PERC H975i, о которой мы подробнее расскажем в разделе, посвященном управлению.

В разделе, посвященном управлению, мы подробнее расскажем о том, как это работает. Благодаря расположению PERC H975i в передней части сервера он не занимает слоты PCIe в задней части. Это очень удобно, если в сервере высотой 1U мало слотов.

Между памятью и БП — силовые разъёмы для прожорливых NIC или GPU.

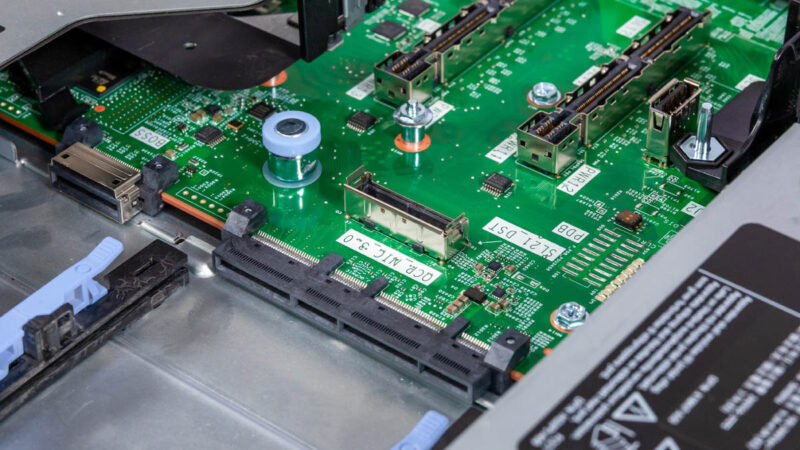

В центре — основные x16 разъёмы для райзеров.

Еще одна небольшая особенность: в случае необходимости увеличения пропускной способности PCIe в слоте предусмотрен дополнительный кабельный разъем для сетевого адаптера OCP NIC 3.0. Это стало очень распространенным конструктивным решением в новых серверах.

Перед вами плата управления Dell iDRAC. Она обеспечивает работу задних портов ввода-вывода и функции BMC.

Это небольшая деталь, но мы решили, что стоит ее показать. В центре корпуса Dell есть направляющая для кабелей и воздушных потоков. Может показаться, что это мелочь, но такие детали довольно редко встречаются в гипермасштабируемых серверах. Не забывайте, что кто-то должен был продумать все возможные варианты прокладки кабелей, проверить, как они влияют на воздушный поток, а затем установить их в систему.

Сзади — варианты со слотами OCP NIC 3.0. Внутренняя фиксация экономит место на задней панели, но замена NIC занимает больше времени. Один из двух слотов помечен под Dell BOSS-карту.

Топология системы

Стоит отметить, что в этом поколении Intel серьезно подошла к вопросу кэширования: в процессорах Xeon 6767P объем кэш-памяти L3 составляет 336 МБ, а кэш-памяти L2 — 2 МБ на ядро. Ранее Intel использовала гораздо меньший объем кэш-памяти, поэтому Granite Rapids — это заметный шаг вперед. Обычно 64-ядерные процессоры AMD EPYC Turin имеют всего 256 МБ кэш-памяти L3 на процессор, хотя и поддерживают 12-канальную память.

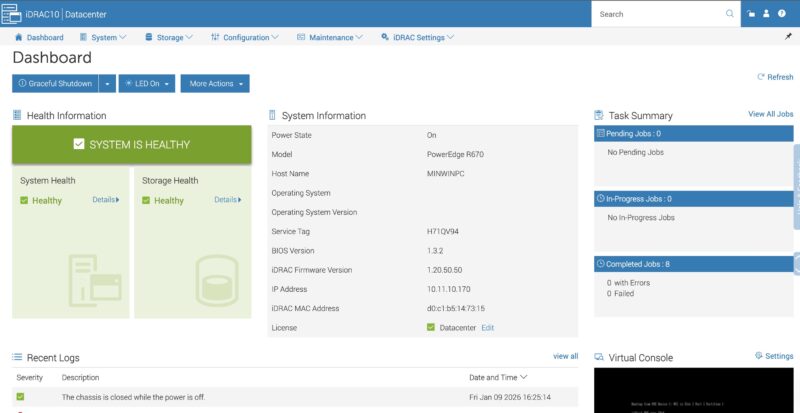

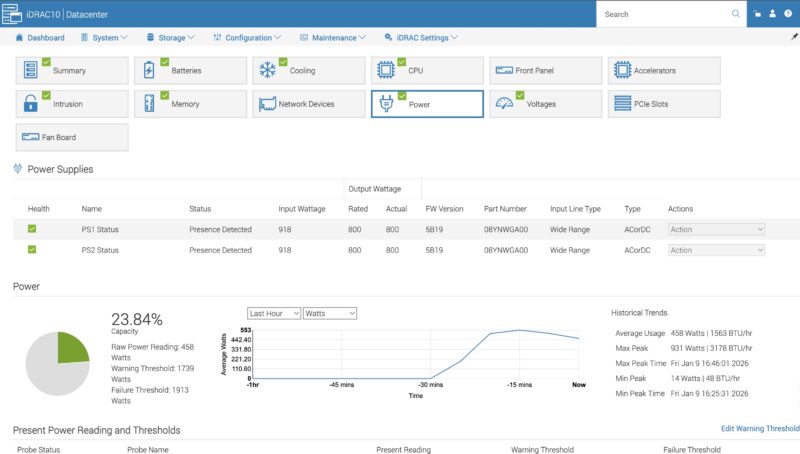

Управление через iDRAC Management

Dell использует iDRAC для управления, и вместо стандартного для отрасли BMC ASPEED AST2600 компания использует собственный чип. Кроме того, интересно, что Dell не обращается напрямую к крупному производителю, а использует Kingston eMMC в своем модуле. Обычно от крупных производителей серверов мы ожидаем увидеть микросхемы Micron, Samsung, SK hynix или Kioxia, как в случае с микросхемами DRAM от Micron.

Если вы работали с iDRAC раньше, то в интерфейсе управления iDRAC 10 вы будете чувствовать себя как дома. Конечно, как и во всех подобных системах удаленного управления, мы рассмотрим версию с графическим интерфейсом, но наша главная цель — использовать API для управления парком серверов.

В Dell есть стандартные функции, например возможность детализировать компоненты.

Кроме того, у вас есть все телеметрические данные, необходимые для выявления потенциальных проблем в системах, поскольку в серверах Dell установлено множество датчиков, данные с которых может получать iDRAC.

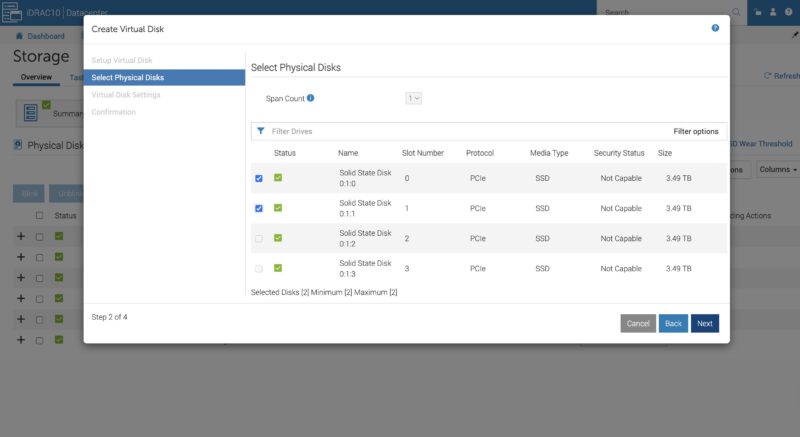

Мы хотели воспользоваться моментом, чтобы подробнее рассмотреть Dell PERC H975i, который установлен в передней части сервера.

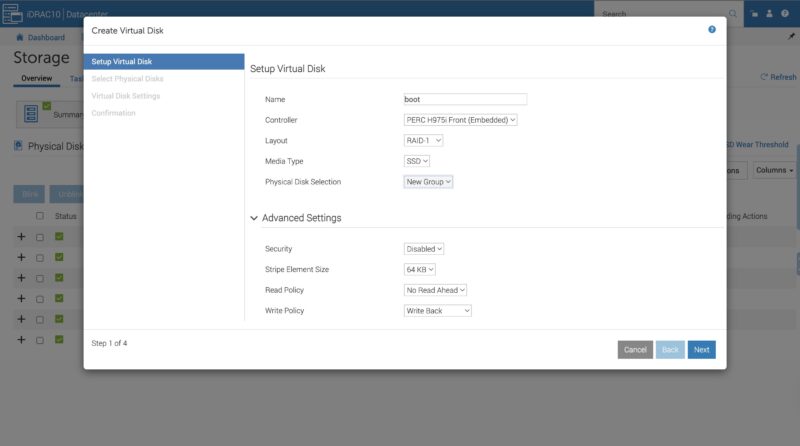

По умолчанию в системе за PERC H975i не отображались диски, поэтому нам пришлось настраивать виртуальные диски. К счастью, iDRAC упрощает эту задачу.

Вы выбираете диски и параметры массива. Готово!

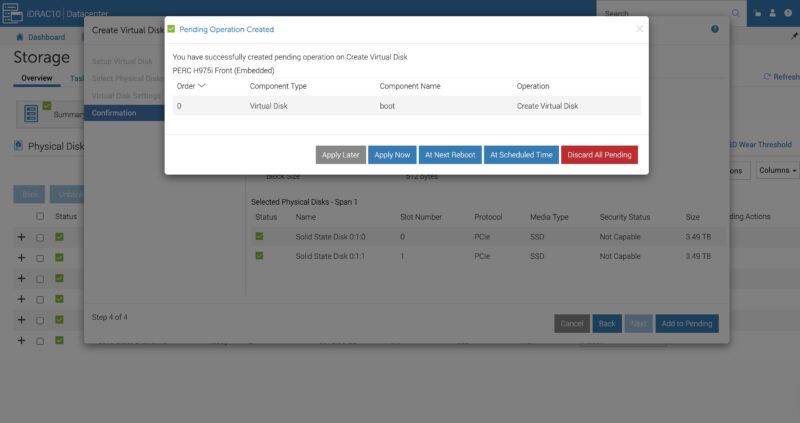

Нажал Apply — задача выполняется в фоне за секунды. Помните старые добрые времена, когда надо было ловить момент с F-клавишами чтобы попасть в интерфейс RAID-контроллера? Забудьте. Это полная противоположность.

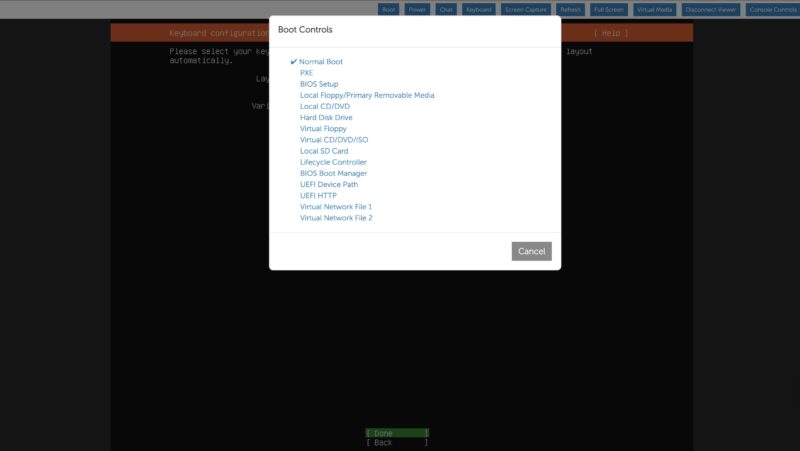

После настройки дисков — подключаем удалённую консоль и ставим Ubuntu прямо из iDRAC. Удобно.

В качестве небольшой заметки отметим, что одна из замечательных функций, повышающих удобство использования, — это экран управления загрузкой. Вы можете выбрать, куда будет загружаться система, в том числе в BIOS или на виртуальный диск, до начала перезагрузки. Как и в случае с RAID-контроллером, если вы помните, что для входа в BIOS нужно нажимать определенные клавиши при загрузке, то теперь в этом нет необходимости. Эта функция есть не у всех производителей, но она очень удобна.

Производительность

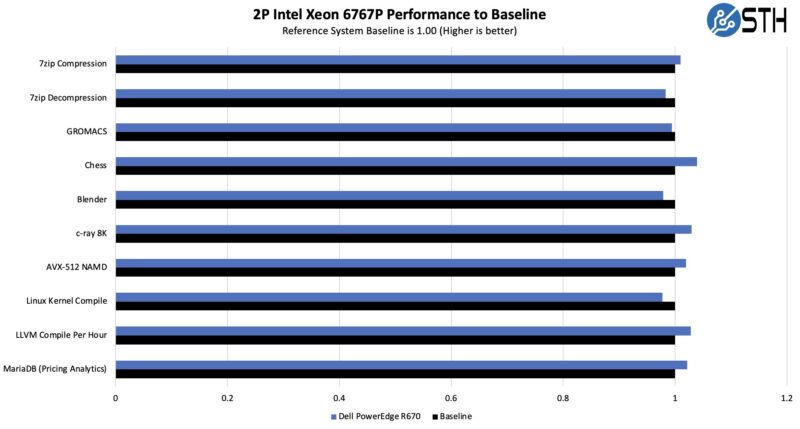

Что касается производительности, то мы уже не раз тестировали процессор Intel Xeon 6767P, учитывая его популярность.

НЗабавный факт: нумерация процессоров Dell сильно отличается от нумерации процессоров почти всех других производителей в отрасли. Dell нумерует первое ядро процессора как ядро с индексом 0, затем первое ядро процессора с индексом 1 и далее чередует их. Для специалистов Dell это логично. Если вы привыкли работать с другими серверами, то привязка ядер в скриптах будет немного отличаться. К счастью, у нас есть версии для Dell, так что мы можем использовать наш стандартный набор инструментов для тестирования этих процессоров.

Главный вопрос: справится ли 1U корпус с охлаждением двух Xeon 6767P при TDP 350 Вт? Ответ — однозначно да. Для 1U сервера — это отличный результат.

На заметку: конфигурация PowerEdge R670 с двумя процессорами Intel Xeon 6767P указана на SPEC.org, так что, если вы используете ее в своих запросах предложений, у нее есть официальный номер.

Теперь давайте поговорим о энергопотреблении.

Энергопотребление

Два БП по 800 Вт 80Plus Platinum. Оба нужны: два по 350 Вт + NIC + охлаждение + SSD + память = точно за 800 Вт.

Dell мониторит не только CPU и БП, но и потребление DRAM — 17–19 Вт на сокет в простое (1 DPC, 64 ГБ DDR5 RDIMM). Итого 120–140 Вт на сокет в idle без учёта остальных компонентов.

В простое система кушает 420–460 Вт, под нагрузкой — 930–950 Вт (без мощных NIC). Воткнули два NVIDIA ConnectX-7 400GbE с оптикой DR4 — и перевалили за 1 кВт.

Звучит много? По сравнению с современными AI-серверами — это копейки на юнит.

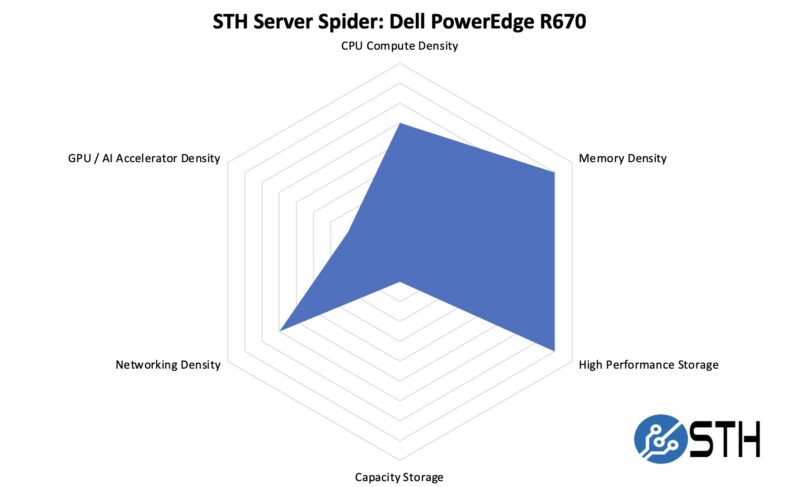

STH Server Spider: Dell PowerEdge R670

Несколько высокоскоростных PCIe Gen5 NIC сзади + до 20 E3.S NVMe SSD спереди = отличная гибкость даже для одноузлового 1U. Плотность — главная суперсила 1U серверов, и тут это видно. Если нужны 3,5" HDD или GPU/AI-ускорители — для них есть более заточенные платформы.

Итого

По наличию передних портов ввода-вывода, отличных модулей вентиляторов, множеству вариантов задней панели, эффективному охлаждению процессоров, поддержке PERC и iDRAC и даже по таким мелочам, как органайзер для кабелей и направляющая для воздушного потока на задней панели, видно, что команда дизайнеров Dell отлично поработала над PowerEdge R670.

Добавление отсеков E3.S — отличное решение, которое предлагает нечто совершенно новое: еще больше места для хранения данных при габаритах 1U. Теперь легко получить 1 ПБ/U (или больше) с помощью стандартных вычислительных серверов, а также сеть со скоростью 400 Гбит/с на порт. Конечно, можно использовать менее емкие накопители или сетевые карты, а также установить три графических процессора NVIDIA на задние панели.

В целом Dell PowerEdge R670 демонстрирует, чего можно добиться, когда отличная команда инженеров работает над повышением производительности и плотности размещения компонентов в стандартных серверах высотой 1U.